[Paper-NLP] ALBERT: A Lite BERT for Self-supervised Learning of Language Representations

ALBERT 在 2017 年 Transformer 的誕生,突破了 RNN、LSTM、GRU … 等在計算上的限制,也帶來新的觀點,爾後再 2018 年底 Google 發表了 BERT: Pre-training of Deep …

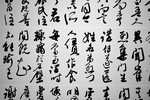

[Paper-NLP] Is Word Segmentation Necessary for Deep Learning of Chinese Representations?

Chinese word segmentation (CWS) NLP 領域在近年的突破性發展,各項研究應用與相關論文不斷的推層出新,對於如何讓機器能更了解文章、句子所表達的內容,進而解決各項在 NLP 領域上的問題,在 OpenAI 近期推出的 GPT-3 …

Transformer Part 3 - Transformer

Transformer 拖延了很久,終於有時間拉把欠的部分補齊了,來講在 NLP 已經廣為人知的 Transformer。在開始介紹前先來附上 transformer 的結構,如下圖:

Image credit: Lil's Log …

Transformer Part 2 - Attention

Attention Mechanism Attention 的概念在 2014 年被 Bahdanau et al. [Paper 1] 所提出,解決了 encoder-decoder 架構的模型在 decoder 必須依賴一個固定向量長度的 context …

Transformer Part 1 - Seq2Seq

一開始接觸 Attention Is All You Need 這篇論文是從 Kaggle Reading Group 這個 channel 開始,非常推薦可以跟著一起讀!!

主持人 Rachael Atman 本身是 Kaggle 的 Data Scientist,她 …

Adversarial validation

在重新回顧 Kaggle 近期的 IEEE-CIS Fraud Detection 的比賽中,發現有人提到一個 Features selection 的方法 Adversarial validation。

Problem 在建立模型時常常都會遇到 training …

Lookahead Optimizer: k steps forward, 1 step back

Introduction 在目前的 optimizer 分為兩個主要發展方向:

Adaptive learning rate, such as AdaGrad and Adam Accelerated schema (momentum), such as Polyak …

Faster R-CNN

Faster R-CNN 是由 object detection 的大神 Ross Girshick 於 2015 年所提出的一個非常經典的目標檢測(object detection)的方法,當中提出了 Region Proposal Networks 的方法應用在提取 …

Word2Vec

最近剛好看到一篇關於 Skip-gram word2vec的介紹,內文寫的淺顯易懂,衍生的閱讀也十分詳細,決定動手寫篇記錄下來。

人對於文字的理解,可以很簡單的就能了解字面的意義,但是對於機器來說,要如何理解文字是一個很困難的問題。 要如何讓機器來理解文字的意義? 透過 …

DropBlock

Dropout 相關方法:

Dropout: 完全隨機丟棄 neuron Sparital Dropout: 按 channel 隨機丟棄 Stochastic Depth: 按 res block 隨機丟棄 DropBlock: 每個 feature map …